通义千问是否内置embedding模型

在当今的自然语言处理(nlp)领域,embedding模型已经成为一种不可或缺的技术。那么,备受关注的通义千问是否也搭载了这种模型呢?本文将详细探讨这一问题。

通义千问与embedding模型

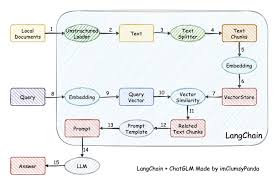

通义千问确实搭载了embedding模型。这种模型主要用于将文本数据转换为高维度的向量表示,从而方便后续的机器学习或深度学习任务。在自然语言处理领域,embedding模型能够捕捉单词之间的语义关系,提高模型的理解和生成能力。通过词嵌入技术,相似的单词会被映射到向量空间中的相近位置,从而帮助模型更准确地理解语境和语义。

通义千问embedding模型的特点

通义千问搭载的embedding模型不仅具备基本的文本向量化功能,还拥有多个显著的特点:

1. 多语言支持:该模型能够支持全球多个主流语种,满足不同地区和国家的需求。这种多语言支持的特性使得模型在跨语言文本处理和分析中表现出色。

2. 统一向量空间:模型为不同语言提供统一的向量空间,便于跨语言的文本处理和分析。这一特性使得模型在处理多语言文本时更加高效和准确。

3. 高效的文本转换:模型能够迅速将文本资料转换为高质量的向量数据,加速后续数据处理速度。这种高效的文本转换能力使得模型在需要大规模文本分析的应用场景中表现出色。

4. api和sdk支持:通义千问提供了丰富的api接口和sdk支持,方便开发者调用和集成模型。这些工具不仅简化了开发流程,还提高了开发效率。

使用通义千问embedding模型的示例

以下是一个使用通义千问embedding api的简单示例:

```python

from dashscope import textembedding

def prepare_data(path, batch_size=25):

数据准备代码(此处省略)

pass

def generate_embeddings(news):

rsp = textembedding.call(

model=textembedding.models.text_embedding_v1,

input=news

)

embeddings = [record[⁄'embedding⁄'] for record in rsp.output[⁄'embeddings⁄']]

return embeddings

假设已经准备好了数据

news_data = ["这是一条新闻", "这是另一条新闻"]

embeddings = generate_embeddings(news_data)

```

在这个示例中,我们首先导入了textembedding模块,然后定义了prepare_data和generate_embeddings两个函数。prepare_data函数用于准备数据(这里省略了具体实现),而generate_embeddings函数则用于生成文本向量。我们使用textembedding.call方法调用api并传入模型名称和输入数据,最终得到文本向量列表。

总结

综上所述,通义千问确实搭载了embedding模型,并且这些模型在自然语言处理任务中发挥着至关重要的作用。通义千问的embedding模型凭借其高维度向量生成能力、高效处理能力和多语言支持等优势,在自然语言处理领域具有广泛的应用前景。无论是进行文本相似度计算、语义搜索还是其他nlp任务,这些模型都能提供强大的技术支持。对于开发者来说,通义千问的embedding模型无疑是一个功能强大且易于使用的工具,为文本数据的快速转换和高质量向量服务的提供奠定了坚实的基础。

- 2025-07-17

- 2025-07-17

- 2025-07-16

- 2025-07-16

- 2025-07-15

- 2025-07-14

- 2025-07-14

- 2025-07-14

- 2025-07-13

- 2025-07-13

- 2025-07-13

- 2025-07-13

- 2025-07-12

- 2025-07-12

- 2025-07-11